En el imaginario colectivo racionalidad e inteligencia suelen ser propiedades mentales que se asocian de manera casi automática: son propiedades similares o, al menos, que presentan una fuerte correlación. De hecho, muchas definiciones de inteligencia incluyen características o actitudes asociadas a la racionalidad, aunque no son las que se miden en los test de inteligencia.

Pero tengamos en cuenta que una persona inteligente puede actuar de manera estúpida. Esto no es una contradicción, pues inteligencia se refiere a una buena capacidad mental y estupidez en este caso se da por acciones «imprudentes». Es más, una persona inteligente y racional en unos ámbitos, p.e., un científico competente en un área del saber, puede comportarse de manera irracional cuando habla de temas fuera de su ámbito, por ejemplo, economía o política. No son pocos los casos de científicos naturales totalmente rigurosos en sus investigaciones, pero que discuten con mucho menos rigor y tienen opiniones muy fuertes sobre política. También lo encontramos en científicos sociales comparando su campo de especialidad y otros campos donde no son expertos. Estos pueden haber formado sus opiniones científicas después de años de estudio, pero forman sus opiniones fuera de su ámbito de especialidad de una manera totalmente distinta sin ser capaces de exponer fidedignamente los elementos teóricos más básicos del área donde no son expertos. Ilustrado con un ejemplo, un físico o un biólogo pueden entender perfectamente cómo se forman las teorías científicas pero a la vez tener una opinión muy fuerte sobre el salario mínimo o el control de alquileres sin haber estudiado ni siquiera los modelos más básicos de oferta y demanda (y, por tanto, no saber reproducir fidedignamente las opiniones contrarias) y basar sus opiniones en evidencia defectuosa, como cherry picking. Es decir, a pesar de conocer cómo proceder científicamente a la hora de abordar un tema, ese conocimiento queda ocioso y se utiliza otro método para alcanzar una respuesta: no se hace una revisión sistemática de la literatura después de tener una sólida base teórica en este tema, sino que se opta por el método menos costoso de cherry picking sin conocer ni siquiera los elementos teóricos más básicos e incluso criticando vehementemente los informes de expertos en la materia. Este científico, para más inri, podría estar quejándose constantemente de la poca importancia que se le da a la ciencia en la sociedad y la política, sin darse cuenta del sesgo que esta persona tiene a la hora de aplicar el(los) método(s) científico(s).

En definitiva, parece factible que exista una distinción importante entre tener una buena capacidad mental (tanto a nivel de proceso como de conocimiento) y actuar de manera «racional». En las siguientes secciones explicamos los detalles que justifican tal afirmación.

La inteligencia en un modelo dual de la arquitectura cognitiva

Comenzamos dando una definición de inteligencia. En las teorías tradicionales sobre inteligencia es usual distinguir entre dos tipos. La inteligencia fluida refleja las habilidades de razonamiento. Se mide mediante pruebas de pensamiento abstracto como las matrices de Raven y ejercicios de series numéricas a completar. La inteligencia cristalizada refleja el conocimiento declarado y adquirido a partir de experiencias de aprendizaje culturalmente definidas. Se mide por tareas de vocabulario, comprensión verbal y medidas de conocimiento general. Aunque sustancialmente correlacionados, estos dos tipos de inteligencia reflejan dos aspectos distintos: inteligencia como proceso e inteligencia como conocimiento.

Podemos ahora intentar encajar estas definiciones en un modelo de la mente. Desde que los psicólogos Kahneman (premio Nobel de Economía en 2002) y Tversky iniciaron el enfoque de heurísticas y sesgos en la década de 1970, se ha acumulado una gran cantidad de evidencia en apoyo de la clasificación dual de los procesos mentales. Siguiendo a Kahneman sabemos que podemos clasificar los procesos cognitivos en dos amplias categorías: Sistema 1 (intuición) y Sistema 2 (razonamiento). El primero es autónomo (se ejecuta automáticamente al encontrar el estímulo desencadenante y es independiente del input de los sistemas de control de alto nivel). Además, es rápido, emocional y se basa en heurísticas que pueden generar sesgos. El Sistema 2 es lento, analítico y computacionalmente costoso. Muchos procesos del Sistema 1 pueden operar a la vez en paralelo, pero el procesamiento del Sistema 2 es en gran parte en serie.

El problema del Sistema 1 es que puede producir respuestas subóptimas en entornos no benignos. Un entorno benigno es aquel en el que existen señales útiles que pueden ser explotadas por heurísticas y en los que no existen otros agentes que modifican su comportamiento para aprovecharse de aquellos que recurren al Sistema 1. Entonces, en los entornos hostiles el Sistema 1 puede producir respuestas subóptimas, de ahí que sea necesario el Sistema 2. Para no recurrir a las respuestas del Sistema 1 cuando estas no son adecuadas, deben darse los siguientes tres pasos:

- Detectar el conflicto entre el Sistema 1 y el Sistema 2.

- Interrumpir el proceso del Sistema 1.

- Generar una respuesta alternativa por el Sistema 2.

La respuesta generada por el Sistema 2 se basará en procesos de razonamiento hipotético y simulación cognitiva, aspectos únicos de este sistema. Cuando razonamos hipotéticamente, creamos modelos temporales del mundo y probamos acciones (o causas alternativas) en ese mundo simulado. Sin embargo, para razonar hipotéticamente debemos ser capaces de evitar que nuestras representaciones del mundo real se confundan con las representaciones de situaciones imaginarias. Esta es una capacidad cognitiva crítica que se conoce como desacoplamiento cognitivo, característica esencial del Sistema 2. Veámoslo con un ejemplo1. Supongamos que nos enfrentamos a resolver una matriz de Raven, una de las pruebas típicas en los test de inteligencia. Entonces, debemos obtener la regla por la que se forman los elementos de la matriz. Esto supone testar las distintas reglas que imaginemos en una copia mental de la matriz original, pero sin confundirla con la matriz real (lo que nos llevaría a pensar que la regla que hemos pensado es la real). A medida que las reglas son más complejas, estas simulaciones son más complejas y requieren mayor capacidad computacional. Conceptualmente lo representamos en la siguiente figura:

El desacoplamiento cognitivo es uno de los aspectos fundamentales de la inteligencia fluida. Por tanto, la inteligencia fluida entra en uno de los procesos clave del Sistema 2, el desacoplamiento cognitivo. Para explicar la inteligencia cristalizada, es necesario completar el modelo sobre la arquitectura de la mente.

Inteligencia fluida y racionalidad en el modelo tripartito

Tal como hicimos en la sección anterior, definimos primero dos tipos de racionalidad. El primero es la racionalidad instrumental, optimizar el cumplimiento de fines. La racionalidad instrumental responde a la pregunta sobre qué hacer. Por otro lado, tenemos la racionalidad epistémica, ajustar nuestras propias creencias al mundo real. La racionalidad epistémica responde a la pregunta sobre qué es cierto. En nuestras acciones del día a día tener creencias verdaderas (racionalidad epistémica) es útil para lograr nuestros objetivos (racionalidad instrumental). Más en detalle, si son las posibles acciones,

los posibles estados del mundo y

asigna las consecuencias de cada acción en cada estado del mundo, entonces:

donde es la función de utilidad de von Neumann–Morgenstern y

asigna probabilidades a los estados del mundo. Para maximizar

,

(racionalidad instrumental), necesitamos tener unas creencias cuyo ajuste a la realidad sea el máximo posible,

,

,

y

, i.e., racionalidad epistémica.

En este sentido, debemos entender la racionalidad en la ciencia cognitiva en un sentido normativo, la racionalidad es un continuo que viene dado por las desviaciones de un modelo normativo. No se tiene una noción categórica de racionalidad como la de Aristóteles que al definir la racionalidad e un agente por la propiedad de basar las acciones en la razón, solo da opción a dos categorías. La definición que aquí usamos de racionalidad está empíricamente y operacionalmente fundamentada, además de permitir diferencias de grado entre individuos.

Para entender la racionalidad en la arquitectura de la mente que presentamos en la sección anterior, tenemos que profundizar en esta. Nos basamos en los trabajos de Keith E. Stanovich y sus colaboradores. Para introducirlo, reproducimos el siguiente extracto del bestseller de Daniel Kahneman:

Keith Stanovich and his longtime collaborator Richard West originally introduced the terms System 1 and System 2 (they now prefer to speak of Type 1 and Type 2 processes). Stanovich and his colleagues have spent decades studying differences among individuals in the kinds of problems with which this book is concerned. They have asked one basic question in many different ways: What makes some people more susceptible than others to biases of judgment? Stanovich published his conclusions in a book titled Rationality and the Reflective Mind, which offers a bold and distinctive approach to the topic of this chapter. He draws a sharp distinction between two parts of System 2—indeed, the distinction is so sharp that he calls them separate “minds.” One of these minds (he calls it algorithmic) deals with slow thinking and demanding computation. Some people are better than others in these tasks of brain power—they are the individuals who excel in intelligence tests and are able to switch from one task to another quickly and efficiently. However, Stanovich argues that high intelligence does not make people immune to biases. Another ability is involved, which he labels rationality. Stanovich’s concept of a rational person is similar to what I earlier labeled “engaged.” The core of his argument is that rationality should be distinguished from intelligence. In his view, superficial or “lazy” thinking is a flaw in the reflective mind, a failure of rationality. This is an attractive and thought-provoking idea. In support of it, Stanovich and his colleagues have found that the bat-and-ball question and others like it are somewhat better indicators of our susceptibility to cognitive errors than are conventional measures of intelligence, such as IQ tests. Time will tell whether the distinction between intelligence and rationality can lead to new discoveries.

Fuente: Thinking, fast and slow de Daniel Kahneman.

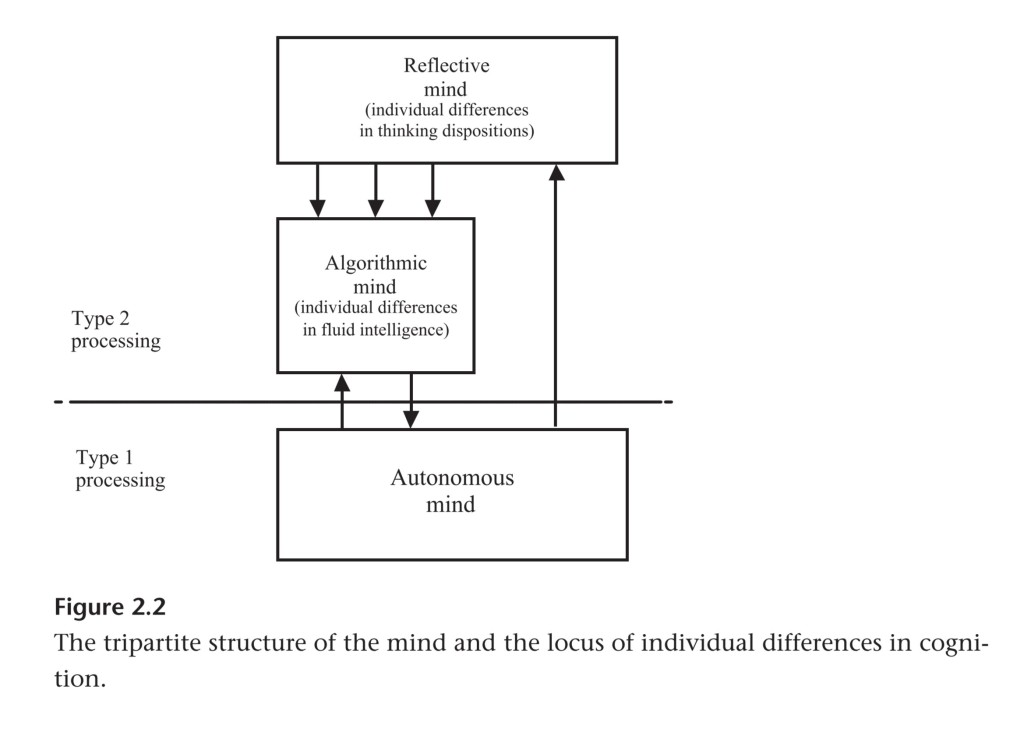

Stanovich presenta evidencia para separar los procesos del Tipo 2 (aunque fue él y Richard West quienes originalmente introdujeron los términos de Sistema 1 y Sistema 2, ahora prefieren hablar de procesos de Tipo 1 y Tipo 2 ya que no sería correcto hablar de dos sistemas completamente separados en el cerebro, sino que los procesos vienen dados por operaciones de subsistemas heterogéneos). Habría dos «mentes» dentro de los procesos del Tipo 2:

- Mente algorítmica: trata con los procesos costosos computacionalmente, procesos en los que interviene la inteligencia fluida o habilidades cognitivas, que sería una medida de la eficiencia de esta mente. Se miden gracias a los test de inteligencia ya que está asociado a las situaciones de rendimiento óptimo, a saber, las reglas de la tarea están dadas externamente al sujeto para que maximice el rendimiento.

- Mente reflexiva: se encarga de los fines del sistema, las creencias relevantes para esos fines y la elección de acciones óptima dados los dos elementos anteriores. Diferencias en las operaciones reflexivas provocarían diferencias en los estilos cognitivos o en las disposiciones o propensiones al pensamiento (i.e., estructura de las creencias y actitudes hacia el cambio y formación de estas). Por ejemplo, la tendencia a recoger información antes de formarse una opinión sobre un tema estaría incluida en las disposiciones al pensamiento. Estos procesos no se miden en los test de inteligencia y estarían más asociados a las situaciones de rendimiento típico donde hay menos restricciones a la acción del sujeto, que no recibe instrucciones para maximizar el rendimiento.

Notemos que para alcanzar la racionalidad se deben tener creencias bien calibradas sobre el mundo y actuar en consecuencia para alcanzar nuestros fines. Esto obviamente implica a la mente reflexiva, pero también a la mente algorítmica pues esta permite procesar el entorno para calibrar las creencias y tomar las acciones necesarias. Las dos mentes están implicadas en la racionalidad, no solo la mente algorítmica. Por tanto, salvo que hubiese una correlación perfecta entre las habilidades cognitivas y la propensión al pensamiento, una gran inteligencia fluida no tiene por qué implicar racionalidad. En la siguiente figura podemos ver esquemáticamente lo presentado arriba.

Podemos analizar ahora con más detalle las funciones de cada una de las mentes. Para ello, nos basamos en la siguiente figura que completa a la anterior:

Pasamos a explicar cada una de las flechas que conectan los distintos compartimentos:

- A: es el proceso por el que la mente algorítmica invalida la respuesta de la mente autónoma.

- B: el proceso anterior se ha iniciado en la mente reflexiva, que da órdenes a la mente algorítmica una vez ha detectado el conflicto entre las respuestas del Sistema 1 y 2.

- C: el desacoplamiento evita la confusión del mundo real con las representaciones imaginarias de este necesarias para la simulación de la respuesta alternativa por parte de la mente algorítmica.

- D: de nuevo, el proceso de inicio de la simulación por desacoplamiento viene dado por la mente reflexiva.

- E: la respuesta viene dada por la mente algorítmica, pero por un proceso distinto a la simulación vía desacoplamiento, que llamamos asociación cognitiva en serie (SAC por sus siglas en inglés), ver más abajo para los detalles.

- F: igualmente, el proceso de iniciar el control de esta respuesta viene dado por la mente reflexiva. Este servirá para iniciar un nuevo proceso SAC con un modelo distinto (E’) o una simulación (C).

- G: esta flecha hace referencia al input que recibe el Sistema 2 del Sistema 1 e incluye la información del entorno que se acumula de manera subconsciente. El Sistema 2 después procesa la información más prominente o de mayor relevancia.

La SAC es un tipo de proceso del Sistema 2 que no implica razonamiento hipotético, ya que razonamiento hipotético siempre implica al Sistema 2 pero la proposición recíproca no es cierta. En la SAC no se simulan de manera completa modelos alternativos del mundo, sino que el proceso cognitivo se basa en un procedimiento asociativo con base en un modelo del mundo dado que es fácil de construir. Un ejemplo de este proceso serían los framing effects o efectos marco. En concreto, el efecto por el cual las personas responden de manera diferente dependiendo de las diferentes formulaciones de un problema equivalente. Cuando se les presentan ambas versiones del problema juntas, la mayoría de la gente está de acuerdo en que los problemas son simplemente redescripciones de la misma situación y que la redacción alternativa no debería haber marcado la diferencia. Por ejemplo, no se valoran igual productos alimenticios en los que se dice que el 94% está libre de grasa a los que se dice que el 6% es grasa aunque son equivalentes. Kahneman afirmó que «el principio básico del efecto marco es la aceptación pasiva de la formulación dada». El encuadre presentado al sujeto se toma como focal, y todo pensamiento posterior deriva de él y no de encuadres alternativos porque estos últimos requerirían más reflexión.

Inteligencia cristalizada en el modelo tripartito: necesidad de mindware

Las distintas mentes necesitan información para poder realizar sus procesos y a este conjunto de conocimientos, reglas, procesos y estrategias lo denominaremos mindware. Esto podemos verlo de manera esquemática en la siguiente figura.

La mente reflexiva accede no sólo a las estructuras de conocimiento general, sino, también a las opiniones, creencias y estructura de fines adquiridos de manera reflexiva. La mente algorítmica accede a microestrategias y reglas para operaciones cognitivas. Finalmente, la mente autónoma no solo accede a bases de conocimiento encapsuladas compiladas evolutivamente (ENB), sino que también recupera información que se ha compilado estrechamente y se activa automáticamente como resultado de aprendizaje y práctica (TCLI). Sin embargo, debemos diferenciar este conocimiento del usualmente medido en los test de inteligencia (en particular, cristalizada). Como dicen Stanovich y West:

…the relevant mindware for our present discussion is not just generic procedural knowledge, nor is it the hodge-podge of declarative knowledge that is often used to assess crystallized intelligence on ability tests. Instead, it is a very special subset of knowledge related to how one views probability and chance; whether one has the tools to think scientifically and the propensity to do so; the tendency to think logically; and knowledge of some special rules of formal reasoning and good argumentation.

Stanovich y West, 2008.

Es decir, el conocimiento necesario para el pensamiento racional es especializado y se agrupa entorno al razonamiento probabilístico, causal y científico. Por el contrario, el conocimiento cristalizado evaluado en las pruebas de cociente intelectual está diseñado deliberadamente para no estar especializado ya que se diseña para garantizar que la muestra de vocabulario y conocimiento sea justa e imparcial. Se intenta que la muestra refleje ampliamente vocabulario, dominios de comprensión verbal y conocimiento general. En resumen, la inteligencia cristalizada, como se mide tradicionalmente, no evalúa diferencias individuales en la racionalidad.

El cognitive miser y los problemas de mindware: taxonomía de los errores de pensamiento

Las personas son cognitive misers (cognitivamente avaras) porque usan por defecto los mecanismos de bajo gasto computacional. Hay dos formas de hacer esto, considerar por defecto procesos del Tipo 1 o considerar por defecto procesos del Tipo 2 de bajo gasto computacional, como la asociación cognitiva en serie (SAC por sus siglas en inglés). En este proceso se usa un modelo focal que es el cognitivamente más fácil de construir. Estos suelen coincidir con los modelos en los que la persona cree previamente (myside bias, belief bias). Podemos aclarar aquí una confusión importante. No todos los procesos normativamente correctos vienen dados por el Sistema 2 ni todos los normativamente incorrectos vienen dados por el Sistema1. La SAC con un modelo sesgado es un ejemplo del del segundo caso al igual que los procesos del Sistema 2 donde la simulación se realiza con mindware «contaminado», ver detalles más abajo. Ejemplos del Sistema 1 dando una respuesta normativamente correcta serían aquellas dadas en entornos benignos o aquellas usando TCLI de mindware automatizado por mucha práctica. El resultado que se ajusta más a la realidad es que es estadísticamente más probable que el procesamiento de Tipo 1 de una respuesta normativamente incorrecta y el procesamiento de Tipo 2 lo cancele con la respuesta correcta.

Para un pensamiento racional, tienen que darse tres procesos mentales:

- Se debe detectar la necesidad de cancelar la respuesta de un «procesamiento avaro».

- Se debe disponer del mindware necesario para la simulación de la respuesta normativamente correcta.

- Se debe disponer de la capacidad algorítmica para simular la respuesta correcta.

Estos procesos están interrelacionados. Por ejemplo, solo si se dispone del mindware necesario y se detecta el conflicto entre el Sistema 1 y Sistema 2 se podrá anular la respuesta del Sistema 1 y generar una normativamente correcta del Sistema 2. Si alguna de las dos condiciones anteriores falla, nos veremos abocados a una respuesta de «procesamiento avaro». Por otro lado, a medida que el mindware esté más automatizado, será más fácil tanto la detección como la generación de la respuesta. En el extremo, la respuesta vendrá dada de manera automática por el Sistema 1. Podemos entonces establecer una taxonomía de los errores de pensamiento:

Tenemos entonces errores de proceso (cognitive miser) y errores de conocimiento (mindware problems). Los errores de pensamiento pueden tener componentes en ambos tipos y la frontera entre ellos puede ser difusa. Por ejemplo, una regla bien aprendida que no se aplica adecuadamente es un caso override failure. Como la regla se requiere cada vez menos, en algún momento está tan mal compilada que no es factible recuperarla en el proceso de anulación y, por lo tanto, el error de anulación se convierte en un error debido a una falta de mindware. En resumen, un error de proceso se ha convertido en un error de conocimiento.

Podemos poner algunos ejemplos para clarificar la clasificación anterior.

- Problema de la pelota y el bate: este archiconocido ejemplo ilustra la respuesta por defecto de la mente autónoma. Recordemos que el problema consiste en: un bate y una pelota cuestan $1.10 en total. El bate cuesta $1 más que la pelota. ¿Cuánto cuesta la pelota? Al responder a este problema, muchas personas dan la primera respuesta que se viene a la mente, 10 centavos, sin pensar más y sin darse cuenta de que esto no puede ser correcto. El Sistema 2 no está involucrado en ningún momento.

- El silogismo de la rosa: este ejemplo ilustra el fallo en anular la respuesta del Sistema 1 por el Sistema 2. El silogismo es: todas las flores tienen pétalos; todas las rosas tienen pétalos; por tanto, todas las rosas son flores. Este silogismo es inválido. Los sujetos deben suprimir la tendencia a respaldar una respuesta válida debido a la «naturalidad» de la conclusión: todas las rosas son flores. Esto es especialmente cierto dado que las instrucciones de la tarea suelen sensibilizar a los participantes sobre posibles conflictos (entre la validez del argumento y la veracidad de las conclusiones y premisas).

- Tarea de selección de Wason: este caso sirve para ilustrar la SAC. El problema es el siguiente: si una carta tiene una vocal en el lado de la letra, entonces tiene un número par en el lado del número. Dos de las tarjetas tienen el lado de la letra hacia arriba y dos de las tarjetas tienen el lado del número hacia arriba. Su tarea es decidir qué carta o cartas deben darse la vuelta para saber si la regla es verdadera o falsa. Indique qué tarjetas deben darse la vuelta. Las cuatro cartas que se le presentan al sujeto muestran caras con K, A, 8 y 5. La respuesta correcta es A y 5, las únicas dos tarjetas que podrían mostrar la falsedad de la regla. Sin embargo, la mayoría de los sujetos responden incorrectamente A y 8. El sujeto usa la SAC porque asume que la regla es cierta, sin entrar en el proceso más costoso de simular las consecuencias del mundo alternativo donde la regla es falsa y, por tanto, el número impar puede tener una vocal en su otra cara2.

- Falacia del jugador: es una falacia lógica por la que se cree erróneamente que los sucesos pasados afectan a los futuros en lo relativo a actividades aleatorias independientes, como en muchos juegos de azar. Esto puede deberse a una falta de conocimientos de probabilidad, lo que puede llevar a situaciones donde no se da una respuesta racional como en la ludopatía. Algo similar ocurre con los conocimientos financieros.

- Creencias supersticiosas como astrología, psicoquinesia, suerte en general, lectura de la mente, números y posesiones de la suerte, objetos desafortunados, horóscopos y predecir el futuro: esto sería un ejemplo de mindware disfuncional, si las simulaciones del Sistema 2 se llevan a cabo con ese mindware, la respuesta distará de ser óptima.

Las habilidades cognitivas son relativamente independientes de los sesgos de pensamiento

Como hemos visto, la irracionalidad (mejor dicho, un distanciamiento pronunciado de la actitud racional) podría lograrse incluso si la mente algorítmica está «altamente desarrollada». Existe evidencia de que las disposiciones de pensamiento son relativamente independientes de las capacidades cognitivas, (Stanovich y West, 2008). Por ejemplo, no existe una correlación significativa entre la magnitud de algunos sesgos clásicos popularizados por Kahneman en su libro Thinking, fast and slow y las habilidades cognitivas. Otro ejemplo importante es el llamado sesgo de mi lado o myside bias («la gente evalúa la evidencia, genera evidencia y prueba hipótesis de una manera sesgada hacia sus propias opiniones y actitudes previas»). Más concretamente tenemos el efecto de conjunción (Linda problem: se estima más probable que Linda (a la que se describe con rasgos de «izquierdas») sea una cajera de banco y feminista a que sea solo una cajera de banco, violando los axiomas de probabilidad), efectos marco (framing effects) ya discutidos, efectos de anclaje (anchoring effect: tendencia a confiar demasiado en la primera información ofrecida (el ancla) al generar la respuesta), sesgo de resultado (outcome bias: evaluar una decisión aleatoria influenciados por el resultado una vez ha ocurrido), negligencia de la tasa base (cabs problem o paradoja del falso positivo: tendencia a sobreponderar la evidencia de casos individuales y a infraponderar la información estadística violando el razonamiento bayesiano), efectos de «menos es más» (en ciertos contextos se viola la monotonía de las preferencias racionales), sesgo de omisión (la tendencia a evitar acciones que conllevan algún riesgo pero que evitarían un riesgo mayor), sesgo de mi lado (myside bias), efecto de coste hundido y efectos de certeza que violan los axiomas de la teoría de la utilidad esperada (p.e., el problema de Allais). Para más detalles sobre la descripción de estos sesgos puede verse Stanovich y West (2008) o Stanovich, West y Toplak (2016). Sin embargo, sí se ve que la capacidad cognitiva se correlaciona con la tendencia a evitar algunos sesgos de pensamiento racional, específicamente la tendencia a mostrar negligencia en el denominador (no considerar el denominador en problemas que implican fracciones), coincidencia de probabilidad en lugar de maximizar (probability matching versus maximizing: en un problema de acertar en múltiples ocasiones el resultado de un evento aleatorio dicotómico usar una estrategia de decisión en la que las predicciones son proporcionales a la probabilidad y no predecir siempre usando el resultado más probable), sesgo de creencia (belief bias: la tendencia a juzgar la validez de los argumentos en función de la verosimilitud de su conclusión en lugar de en qué medida apoyan esa conclusión, ver silogismo de la rosa arriba) y sesgo de selección en las 4 cartas de Wason discutido arriba.

Como hemos comentado, la inteligencia fluida solo es importante cuando no hay un mindware gap (por ejemplo, falta de probabilidad o conocimiento lógico) y se detecta la necesidad de anular las respuestas heurísticas. Esto permitiría explicar por qué algunos sesgos se correlacionan con la inteligencia y por qué otros no. Por ejemplo, en el silogismo de la rosa sí se detecta la necesidad de suprimir la respuesta heurística, pero no en el problema de Linda. Notemos que el problema de Linda ilustra cómo no es suficiente disponer de conocimiento para la racionalidad (lógico o probabilístico), también se tiene que tener la tendencia a usarlo cuando es necesario suprimir la respuesta instintiva del Sistema 1. Muchos de los estudiantes del experimento tenían el conocimiento de probabilidad necesario, i.e., , pero aún así cayeron el la falacia de la conjunción. Un punto importante es que las disposiciones al pensamiento, en contraste con las habilidades cognitivas, se consideran más maleables y esto predeciría que estas habilidades son más fáciles de enseñar y corregir.

Hay algunos sesgos que se correlacionan con las habilidades cognitivas como la prueba de evaluación de argumentos (Stanovich y West, 2008). En estas pruebas, los sujetos deben evaluar los argumentos en favor de ciertas proposiciones (de las que se les ha preguntado su opinión previamente, p.e., impuestos, control de armas…). Una característica diferenciadora de estos experimentos es que no son naturalistas o similares a una situación de la vida real porque se les ha dicho a los sujetos que desacoplen sus creencias previas de la evaluación de la evidencia. Entonces, la correlación ocurre porque «los participantes de diferentes capacidades cognitivas tienen diferentes niveles de poder computacional disponibles para las operaciones de supresión que hacen posible el desacoplamiento», (Stanovich, West y Toplak, 2013).

La racionalidad en la esfera política

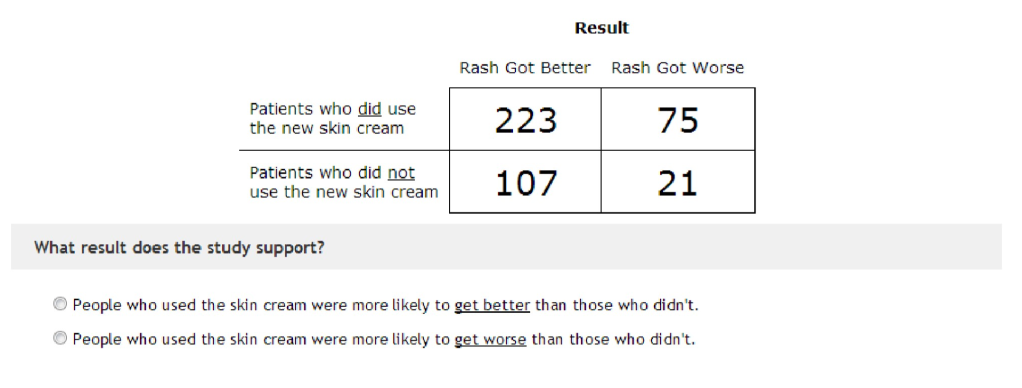

Mayor inteligencia fluida podría empeorar las cosas en el sesgo mi lado, myside bias. En efecto, en Kahan et al.3 podemos ver por qué. En este experimento, los sujetos deben extraer una inferencia causal válida a partir de datos empíricos. Los mismos datos empíricos se presentan de dos maneras: de una manera ideológicamente neutra (tratamiento de erupciones cutáneas) y como una cuestión partidista (prohibición del control de armas). La presentación de los datos en el primer caso se puede ver en la figura siguiente:

En el primer caso (como era de esperar), cuanto mejores son las habilidades matemáticas, mejores son las respuestas, pero en el segundo caso (control de armas) las respuestas se polarizaron entre los grupos políticos estadounidenses de liberal democrats (izquierda) y conservative republicans (derecha), se volvieron menos precisas y empeoraron para los sujetos con mayor capacidad de aritmética (inteligencia algorítmica), lo que los autores llaman habilidades aritméticas motivadas4 (motivated numeracy). Esto podría verse como un conflicto entre ser epistémicamente racional (ajustar las creencias de uno al mundo real, lo que es cierto) e instrumentalmente racional (optimizar el cumplimiento de los fines, qué hacer), como definimos más arriba. Como ya vimos, en nuestras acciones cotidianas, tener creencias verdaderas (racionalidad epistémica) es útil para lograr nuestros objetivos (racionalidad instrumental). Pero en los casos de política, este razonamiento motivado puede ser el medio para lograr nuestros objetivos porque compartir algunas opiniones políticas es un símbolo de pertenencia y lealtad en los grupos políticos, la racionalidad expresiva, que puede ser más valiosa que los fines epistémicos. En el proceso político nuestras creencias se desligan de sus consecuencias (nuestras creencias sobre el control de armas tienen poca probabilidad de afectar a las decisiones políticas y sus consecuencias). Entonces, la racionalidad expresiva tiene todo el sentido, ya que la racionalidad epistémica e instrumental no están necesariamente vinculadas y tener creencias verdaderas sobre el mundo es menos valioso que rechazar las creencias del grupo al que pertenecemos o queremos pertenecer. Nuestros fines son distintos a descubrir el estado real del mundo, luego podemos ser racionales (instrumentalmente) aunque no seamos racionales a nivel epistémico. Como dice el psicólogo social Jonathan Haidt, somos buenos racionalizadores pero malos razonadores cuando hablamos de política. La irracionalidad racional fue investigada y aplicada al proceso político, entre otros, por el economista Bryan Caplan (por ejemplo, ver Caplan, 2000). Los autores argumentan que para lograr una respuesta epistémicamente racional, podría ser más útil, por ejemplo, adoptar medidas que protejan eficazmente la ciencia relevante para la toma de decisiones del razonamiento motivado que protege la identidad: comportarse como un hooligan deportivo no debe ser visto como una forma apropiada de procesar la información. En una réplica reciente (prerregistrada) de este estudio (Persson et al., 2021), se encontró el efecto del razonamiento motivado, pero no estaba tan claro el efecto de motivated numeracy (el razonamiento motivado aumenta con la capacidad aritmética). Stanovich y Kahan (2016) analizan un caso similar con respecto a la aceptación de la teoría de la evolución5, la religiosidad y una prueba de reflexión cognitiva (que se miden con un test de tres elementos similares al problema de la pelota y el bate, CRT test). Podríamos pensar que hay dos tipos de hipótesis y estas se presentan en la siguiente figura:

La figura refleja las dos hipótesis que pasamos a describir. La hipótesis BRD (Bounded Rationality Disbelief) ve la incredulidad (disbelief) en la evolución como una consecuencia de la dependencia excesiva del Sistema 1, i.e., las personas que están más dispuestas o son más capaces de usar el pensamiento analítico pueden tener más probabilidades de respaldar la evolución que las personas que tienden a confiar en sus intuiciones. La hipótesis ERD (Expressive Rationality Disbelief), por el contrario, afirma que los seres humanos no siempre usan sus capacidades racionales para conformar sus creencias de acuerdo al conocimiento científico. También lo usan para formar creencias que expresan quiénes son como personas con valores y comprometidas. Como comentábamos arriba:

An individual’s personal behavior as a consumer, voter, or contributor to public discourse is too immaterial to affect the risk posed by emission of greenhouse gases, fracking, nuclear waste disposal, and the like. Accordingly, no mistake a person makes about these risks in any of these capacities will affect her well-being or the well-being of anyone she cares about. But given what beliefs about these risks are widely understood to signify about a person’s cultural outlooks, forming views on them that are out of keeping with one’s peers risks estranging a person from those she most depends on for psychic and material support

Fuente: Stanovich y Kahan, 2016.

Los datos presentados en el estudio confirman la hipótesis ERD. En términos matemáticos, podemos decir que ante el modelo (con un dummy que indica religiosidad,

el número correcto de respuestas en el test y

la probabilidad con estar de acuerdo con la teoría de la evolución)

la BRD predeciría y

y la ERD

y

. Es decir, la clave está en que en la segunda hipótesis el término de interacción no es nulo. En ambos casos

lo que indica un sesgo cognitivo un razonamiento motivado, pero si la ERD es cierta, este razonamiento motivado se intensifica a medida que las capacidades racionales aumentan (

). Como decimos, esto tendría sentido pues:

But because what one believes, no less than what one values, can signify the kind of person one is, a broader level of epistemic rationality places a constraint—one discussed under many different labels (symbolic utility, expressive rationality, ethical preferences, and commitment [Stanovich, 2004])—on truth seeking in certain contexts. Just as immediate desires can be subordinated to “higher ends” in the domain of instrumental rationality, so in the domain of epistemic rationality truth seeking can sometimes be sacrificed to symbolic ends.

Fuente: Stanovich y Kahan, 2016.

Esto es, en el proceso político se desliga la racionalidad instrumental de la epistémica, estos fines epistémicos pueden sacrificarse por fines simbólicos o de otro tipo. Además, estos fines estarán más satisfechos a medida que el sujeto tenga mayor racionalidad. Obviamente, aunque esto sea racional (sentido instrumental) a nivel individual, colectivamente es un desastre: los ciudadanos de estas sociedades tienen menos probabilidades de converger sobre cuál es la mejor evidencia disponible sobre la sociedad.

Conclusión

Como hemos visto, la inteligencia algorítmica puede no ser suficiente para el pensamiento racional, pues es solo una de las componentes de este, dentro de los modelos de arquitectura mental de la psicología moderna que hemos revisado6. Más allá de la separación conceptual, una gran inteligencia, fluida o cristalizada, no garantiza las disposiciones racionales como demuestra la evidencia donde no hay correlación entre capacidades cognitivas y ciertos sesgos de pensamiento. También hemos visto que en el ámbito de la política, la racionalidad instrumental y epistémica dejan de ir de la mano. En ese caso, una mayor racionalidad puede ir en contra de la búsqueda de la verdad, pues este fin deja de ser uno de los más valiosos en nuestra escala de preferencias7. Además, en este caso la racionalidad epistémica requeriría de mayor mindware. Por ejemplo, para dar una respuesta racional en temas de economía, se necesitarían conocer un mínimo de elementos de microeconomía, macroeconomía o econometría.

En definitiva, es importante tener un entendimiento correcto de la racionalidad, tanto a nivel individual como político. La evidencia disponible parece indicar que tener conocimientos científicos o ser inteligente no nos protege contra comportamientos irracionales y podrían jugar en nuestra contra. Por el bien de la sociedad en su conjunto, entendido como ciertos fines compartidos por los individuos que la forman, debemos preguntarnos si realmente podríamos tener comportamientos más racionales y, de manera agregada, pensar en qué sistemas de incentivos o de agregación de preferencias harían que la irracionalidad racional deje de serlo.

Notas

- Ver Koichu et al. (2015) para una aplicación al caso de matemáticas, en particular, el caso de la introducción de los números complejos.

- Una simulación de las diferentes posibilidades o «mundos» refleja que si en una cara tenemos una vocal, en la otra podríamos tener un número par (confirmando parcialmente la regla) o uno impar (rechazando la regla). De manera similar con la cara de un número impar, donde usamos que

. Una posible explicación es que el sujeto no se da cuenta de la equivalencia por un mindware gap. El hecho de tomar la regla como dada, donde aparece una vocal y un número par puede llevar al sujeto, vía SAC, a coger la A y el 8. Notemos que el 8 solo serviría para confirmar (parcialmente) la regla, pero no para rechazarla (8 con consonante es compatible), lo que podría poner de manifiesto un sesgo de confirmación.

- Ver referencias en Kahan et al. (2017) y Kahan y Stanovich (2016) para más evidencia de su hipótesis, que llamaremos ERD más abajo.

- Algunos autores prefieren traducir el término “motivated reasoning” como razonamiento guiado o dirigido, pues motivado implicaría fundamentado, lo contrario a lo que se intenta expresar.

- Se ha analizado este tema, pero podrían haberse analizado otros temas científicos como el cambio climático o de signo contrario como la energía nuclear o medicina alternativa. También temas sociales, como el control de alquileres, donde los grupos de izquierda suelen ir sistemáticamente en contra de la evidencia empírica.

- La inteligencia algorítmica no sería tan necesaria como se podría pensar inicialmente, por ejemplo, si hay «atajos» epistémicamente seguros no sería necesaria una investigación directa o simulación de respuestas alternativas. Por ejemplo, si hay consenso entre los expertos, se puede tomar como la opción más probable. Esto podría reducir la necesidad de inteligencia algorítmica pero no elimina una cantidad mínima; estos atajos son procesos computacionalmente costosos. Además, también sería necesario un mínimo nivel de mindware para ser epistémicamente racional dependiendo del ámbito (incluso usando los atajos epistémicos). Por ejemplo, como comentábamos arriba, para dar una respuesta racional en temas de economía, se necesitarían conocer un mínimo de elementos de microeconomía, macroeconomía o econometría, por ejemplo.

- Para una exposición más accesible de temas similares pueden consultarse los siguientes artículos o entrevistas en prensa de Stanovich:

Referencias

- Caplan, B., 2000. Rational Irrationality: A Framework for the Neoclassical-Behavioral Debate. Eastern Economic Journal, 26(2), 191-211.

- Kahan, D. M., Peters, E., Dawson, E. C. and Slovic, P., 2017. Motivated numeracy and enlightened self-government. Behavioural Public Policy, 1(1), 54-86.

- Kahan, D. M. and Stanovich, K., 2016. Rationality and belief in human evolution. Annenberg Public Policy Center Working Paper, (5).

- Kahneman, D., 2003. Maps of bounded rationality: Psychology for behavioral economics. American economic review, 93(5), pp.1449-1475.

- Koichu, B. and Leron, U., 2015. Proving as problem solving: The role of cognitive decoupling. The Journal of Mathematical Behavior, 40, 233-244.

- Persson, E., Andersson, D., Koppel, L., Västfjäll, D. and Tinghög, G., 2021. A preregistered replication of motivated numeracy. Cognition, 214, 104768.

- Stanovich, K. E., and West,R.F, 2008. On the relative independence of thinking biases and cognitive ability. Journal of personality and social psychology 94.4: 672.

- Stanovich, K.E., 2009. Distinguishing the reflective, algorithmic, and autonomous minds: Is it time for a tri-process theory?, in In two minds: Dual processes and beyond, Oxford University Press, 2009, pp. 55-88.

- Stanovich, K., 2011. Rationality and the reflective mind. Oxford University Press.

- Stanovich, K. E., West, R. F., and Toplak, M. E., 2013. Myside bias, rational thinking, and intelligence. Current Directions in Psychological Science, 22(4), 259-264.

- Stanovich, K.E., West, R.F. and Toplak, M.E., 2016. The rationality quotient: Toward a test of rational thinking. MIT press.

6 thoughts on “Racionalidad e inteligencia, ¿son lo mismo? De los dos sistemas de Kahneman a las tres mentes de Stanovich y las implicaciones en política”